Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

Revista iberoamericana de ciencia tecnología y sociedad

versión On-line ISSN 1850-0013

Rev. iberoam. cienc. tecnol. soc. vol.13 no.37 Ciudad Autónoma de Buenos Aires feb. 2018

MONOGRÁFICO

¿Cómo perciben los investigadores del CONICET al sistema institucional de evaluación de la ciencia y la tecnología?

Como os pesquisadores do CONICET percebem o sistema institucional de avaliação da ciência e da tecnologia?

How do CONICET Researchers Perceive the Institutional Science and Technology Evaluation System?

Jorge Atrio *

* Magíster en ciencia, tecnología y sociedad. Secretario ejecutivo del Centro de Estudios sobre Ciencia, Desarrollo y Educación Superior (REDES), unidad asociada al CONICET. Correo electrónico: jatrio@conicet.gov.ar.

El trabajo presenta parte de los resultados de un amplio relevamiento realizado entre los investigadores del Consejo Nacional de Investigaciones Científicas y Técnicas (CONICET)sobre el sistema de evaluación institucional. Las respuestas obtenidas superan el millar y mediode casos, cifra que evidencia la sensibilidad del tema para nuestra comunidad científica. Elanálisis que se propone pone de relieve una síntesis de aquellos ámbitos que son percibidoscomo críticos y que requieren un tratamiento prioritario en pos del fortalecimiento del sistema ensu conjunto. La mirada del investigador es fundamental para comprender la compleja dinámicade los actuales procesos de generación del conocimiento. No se puede prescindir de estaperspectiva a la hora de planificar nuestro desarrollo científico y tecnológico de cara al futuro. Elanálisis busca hacer un aporte que contribuya a la generación de espacios para el debate. A la luz de las opiniones relevadas, los distintos niveles de gestión se ubican en un lugar privilegiado como los principales motores que deben ponerse en marcha para lograr cambios sostenidos.

Palabras clave: Evaluación científica; CONICET; Evaluación por pares; Criterios de evaluación

O trabalho apresenta parte dos resultados de um amplo levantamento realizado entre os pesquisadores do Conselho Nacional de Investigações Científicas e Tecnológicas - CONICET - sobre o sistema de avaliação institucional argentino. As respostas obtidas ultrapassam mil e quinhentos casos, demonstrando com isso a sensibilidade do assunto para a nossa comunidade científica. A análise proposta como eixo articulador das expressões dos membros da carreira de pesquisa tentará destacar uma síntese das áreas que são percebidas como críticas e que precisem de um tratamento prioritário em prol do fortalecimento do sistema em conjunto. O olhar do pesquisador é fundamental para entender a dinâmica complexa dos atuais processos de geração de conhecimento. Não se pode prescindir dessa perspectiva ao planejar o nosso desenvolvimento científico e tecnológico para o futuro. A partir desse lugar, a análise procura fazer uma contribuição para a geração de espaços para o debate. À luz das opiniões levantadas, os diversos níveis de gestão estão localizados em um lugar privilegiado como os principais motores que devem ser implementados para obter mudanças sustentáveis.

Palavras-chave: Avaliação científica; CONICET; Avaliação por pares; Critérios de avaliação

This work presents part of the results of a broad survey carried out among researchers of the National Council of Scientific and Technical Research (CONICET, due to its initials in spanish) about the institutional evaluation system of

Keywords: Scientific assessment; CONICET; Peer review; Evaluation criteria

Introducción

Este trabajo explora la opinión de una importante cantidad de científicos argentinos respecto de algunas dimensiones en las que se sustentan las prácticas de evaluación en ciencia y tecnología. El contexto estricto que define el alcance del relevamiento desarrollado se ciñe a un ámbito institucional específico, el del Consejo Nacional de Investigaciones Científicas y Técnicas (CONICET) de la República Argentina. Serán las consideraciones de los investigadores de este prestigioso organismo las que guiarán el análisis que se describe en este artículo. El abordaje propuesto se sitúa desde una perspectiva más cercana a la gestión de dichos procesos. En este ámbito se intentará evidenciar aquellos espacios de tensión en los que el científico considera que la valoración de su actividad no contempla el verdadero alcance y la complejidad de dicha tarea.

El texto se sostiene en la premisa de que la dinámica de trabajo del investigador científico se ha modificado en las últimas décadas. Varias teorías han explicado estos procesos de cambio desde distintas vertientes. Entre ellas, consideramos que el enfoque que postulan distintos autores (Echeverría, 2005; Iglesias, 2006) sobre la tecnociencia configura un acervo teórico plausible para el arraigo del análisis que se presenta en estas páginas. Apelar a los conceptos que construye este marco referencial nos permite interpretar de un modo amplio el contexto en el que trabaja el científico. La articulación de nuevos valores, nuevos intereses y nuevos agentes en el terreno propio de la investigación, explica buena parte de las tensiones que surgen en este campo. Comprender ese extenso plano en el que se inserta hoy la producción del conocimiento y sus prácticas de evaluación es de vital importancia para todo estudio del tema. Por ello, la base teórica que le dio marco al relevamiento de opinión que constituye el eje central de este trabajo tuvo presente en todo momento al entorno social como un elemento gravitante. La ciencia actual es interpelada por una comunidad que la reconoce como un activo estratégico; por ello es necesario tener presente las incidencias de este contexto amplio sobre la dinámica de las comunidades de práctica científica y sobre su cultura.

Sobre esa base conceptual se indagaron las dimensiones más relevantes que configuran los procesos de evaluación científica en distintas instituciones. De estamanera, como tarea previa al diseño de la herramienta utilizada para el relevamiento se identificaron las principales instancias de evaluación de organismos de Argentina, España, México y Brasil (ANEP, 2006, 2007 y 2010; CNPq, 2015; CONACYT, 2012; CONICET, 1973, 2006, 2016, 2017a y 2017b). En este recorrido encontramos prácticas comparables, pero con algunas particularidades que nos permitieron comenzar a delinear por dónde pasan los criterios de valoración más utilizados en la ciencia y la tecnología. Adicionalmente a las fuentes documentales y las publicaciones consultadas, también recabamos la opinión de gestores y científicos implicados en estos procesos. Con este objetivo se avanzó en el estudio del estado del arte de nuestro trabajo a través de entrevistas personales. A modo de informantes clave, las consideraciones de estos actores fueron necesarias para anclar las elaboraciones teóricas en un plano axiológico. Conocer los valores que los distintos agentes ponen en juego en sus prácticas cotidianas enriqueció significativamente el análisis. Esto nos permitió identificar aquellos puntos de tensión entre el desarrollo de las prácticas de evaluación y la perspectiva del científico en su doble rol, como evaluador y como sujeto evaluado.

La suma de todas estas actividades previas nos permitió establecer un recorte paraprofundizar el estudio en algunos ejes. Resultó evidente el papel central que en estasprácticas tienen: 1) el sistema de pares evaluadores; 2) el uso de indicadores bibliométricos; 3) la mirada de la trayectoria de los científicos a través de sus currículum vitae; y 4) la incidencia de nuevos actores que hoy buscan una mayor presencia en estos procesos. Como todo recorte, esta selección tiene una cuota de arbitrariedad que no se puede soslayar. Por esto fue también importante tamizar la información con algún mecanismo de validación que nos provea la metodología de investigación. Así, una vez definidas esas cuatro dimensiones, las pusimos a prueba en un trabajo de campo más amplio en el que buscamos conocer la opinión de los investigadores. Esto derivó en una actividad central cuyos resultados son el objeto de este artículo; se trata de un relevamiento materializado a través de una encuesta a los científicos del CONICET. La recepción por parte de esta comunidad de investigación fue muy alentadora. Llegando a un total de 1654 respuestas, se pudo elaborar un escenario que nos permitió comprender más acabadamente las distintas tendencias de opinión que expresan los científicos.

Para el desarrollo de este trabajo hemos optado por centrarnos en la primera de las dimensiones: todo aquello que hace al sistema de pares. Se presentarán cuadros de resultados de las preguntas más significativas de la encuesta, incorporando a su vez una interpretación respecto de esta información que se sustenta en todo el proceso de exploración previa. Sobre las otras dimensiones relevadas, principalmente lo relacionado al uso de indicadores y de los currículum en los procesos de evaluación, se tomarán sólo algunos elementos que contribuyan al análisis. Dicho estudio y las conclusiones con las que se cierra este escrito no pretenden saldar controversias que son de plena vigencia; lo que buscamos es sumar elementos para la discusión. Por todo ello y dada la complejidad del tema que abordamos, la pretensión es promover la apertura de espacios para el intercambio de ideas, buscando de esta forma realizar un aporte para el establecimiento de consensos y para acercar la cultura y los valores de la ciencia a las necesidades del contexto en el que se desarrolla.

1. Metodología

Apelando a los conceptos de Giddens (1987: 159), el mundo social, a diferencia del mundo de la naturaleza, ha de ser captado como una realización diestra de sujetos humanos activos. Para este autor el científico social recurre al mismo tipo de destrezas que las de aquellos cuya conducta procura analizar con el fin de describirla. Por su parte, Watson-Gegeo (1998) sostiene que la investigación cualitativa consiste en descripciones detalladas de situaciones, eventos, personas, interacciones y comportamientos, que son observables. Entonces, en esta línea y a modo de sustento teórico para la posterior elaboración de la encuesta realizada, se articularon distintas metodologías de investigación cualitativa: revisión bibliográfica; exploración de literatura gris (Farace y Schöpfel, 2010) en la que se encuadran normativas, informes, publicaciones oficiales (Gimaraes Almeida, 1998: 54); entrevistas ainformantes clave, entre otras.1 Luego, a partir del método de triangulación (Taylor y Bodgan,1987; Cook y Reichardt, 1986; Bericat, 1998), combinamos estas herramientas con la metodología cuantitativa de la encuesta.

La tarea previa a la realización del relevamiento nos permitió establecer su alcance temático. Así se definieron para la encuesta las siguientes dimensiones:

1. Aspectos relacionados a la gestión y la dinámica del sistema de evaluación por pares

2. Aspectos relacionados al uso de los indicadores bibliométricos en las evaluaciones

3. Aspectos relacionados al uso de los CV como análisis de trayectorias en las evaluaciones

4. Aspectos relacionados al ingreso de nuevos actores en los procesos de evaluación

Es importante destacar, a modo de consideración metodológica, que la incorporación del sistema de evaluación por pares como una dimensión no implica poner en debate esta forma de evaluación. Lo que se buscó indagar es su instancia de implementación y la dinámica de su desarrollo. Se analizaron aspectos de su puesta en práctica que pudieran ser susceptibles de mejoras. Así, esta dimensión que define el cauce central de este trabajo se encuentra a un mismo nivel que las restantes.2 Se trata de dimensiones complejas con herramientas específicas en cada caso.

Las unidades de análisis que constituyen este relevamiento son cada uno de los investigadores que respondieron la encuesta. El universo que conforman la población total de estas unidades de análisis está delimitado por los miembros de la carrera del investigador científico y tecnológico (CIC) del CONICET. Dentro de este universo se realizó la encuesta a un grupo muy representativo, del que se obtuvo la cantidad de 1654 respuestas efectivas.

2. Distribución socio-demográfica de los encuestados

La encuesta fue realizada en el período comprendido entre el 1 de abril y el 15 de mayo de 2017. Los 1654 formularios electrónicos recibidos representan el 16,5% del total de investigadores de la CIC que, a diciembre de 2016, llegaban a ser 10.036 científicos.3 Para establecer el nivel de correspondencia del conjunto de encuestados con la población en estudio, se presenta seguidamente la distribución de ambos grupos en base a diferentes variables relevadas.4

En las proporciones por categoría se verifica una menor participación en la encuesta de los investigadores asistentes respecto de su participación en la CIC del CONICET. A partir de la categoría adjuntos se reduce esta diferencia, siendo solo levemente mayor la participación en cada estrato entre los que respondieron la encuesta. Esta diferencia en la categoría inicial guarda sintonía con la diferenciación del primer rango de edad expuesta en la Tabla 1; esto puede explicarse en parte por la especificidad del tema del relevamiento. La encuesta no era exclusiva sobre aspectos internos de los procesos de evaluación de la ciencia, pero contaba con un conjunto importante de preguntas en dicho sentido. Por este motivo, hubo investigadores de las menores categorías -y edades- que optaron por no responder, autoexcluyéndose por considerar falta de experiencia en el tema.5

Tabla 1. Composición de los encuestados y de los miembros de la CIC según edad

Tabla 2. Composición de los encuestados y de los miembros de la CIC según sexo

Tabla 3. Composición de los encuestados y de los miembros de la CIC según categoría

Tabla 4. Composición de los encuestados y de los miembros de la CIC

Tabla 5. Composición de los encuestados y de los miembros de la CIC según provincia

Tabla 6. Composición de los encuestados y de los miembros de la CIC

Gráfico 1. Composición de los encuestados y de los miembros de la CIC

Salvo este caso particular, el resto de las distribuciones del relevamiento, en todas sus variables, posee una correspondencia muy estrecha con su distribución real en la CIC. Este aspecto es central para conocer el alto nivel de representatividad del grupo relevado respecto de su universo. Finalmente, se destaca que más del 80% de los científicos que respondieron contaba con experiencia como evaluador. De ello se desprende que, en su gran mayoría, las opiniones recibidas correspondan a investigadores que no sólo conocen el sistema de evaluación de la ciencia y la tecnología como sujetos evaluados, sino que además han participado de forma activa en estas prácticas.

3. La mirada de los científicos del CONICET

Tomando entonces como principal hilo conductor del análisis al primero de los cuatro módulos de la encuesta -los aspectos relacionados a la gestión y a la dinámica de la evaluación por pares-, se describen a continuación las respuestas obtenidas en las variables más representativas de dicha dimensión. A todo lo cual, y con el objeto de enriquecer la perspectiva que propone el artículo, se sumarán también algunos datos complementarios surgidos de los restantes módulos del relevamiento.

3.1. Consideraciones sobre la gestión y la dinámica del sistema de pares

Uno de los primeros aspectos indagados sobre la gestión del sistema de pares fue lo relacionado a la forma de selección de estos evaluadores, tanto de los consultoresexternos como de los miembros de los cuerpos colegiados, como las comisiones disciplinares y la junta de evaluación. Para conocer la opinión de los investigadores sobre este aspecto, se les consultó si consideran que en el proceso de evaluación de pares del CONICET se controlan los antecedentes de quienes ya ejercieron ese rol antes de volver a ser convocados. Entre aquellos que sí fueron evaluadores, sin contar a quienes expresaron desconocer el proceso de selección y a quienes optaron por no responder, hubo: 1) 67 casos que consideran que existen controles formales y exhaustivos para seleccionar los pares; 2) 68 casos que creen que no existe ningúntipo de control; y 3) 475 casos que sostienen que hay pocos controles, informales y en función de la experiencia previa de quienes gestionan el proceso. Estas cifrascomienzan a poner de relieve que la gestión de los procesos de evaluación no es unelemento aislado; por el contrario, es preciso incluirla en los debates sobre la puesta en práctica del sistema de pares.

Tabla 7. Consideraciones sobre el control de desempeño previo como evaluador

Estos valores expresan la percepción de que, al menos, existiría cierta falta de rigurosidad en los procesos de selección de los evaluadores. Por otra parte, distintas consideraciones recogidas en las preguntas abiertas de la encuesta resultan de sumo interés para profundizar en la interpretación de esos datos:6

“Conformación en los últimos 13 años de círculos cerrados de evaluadores que representan a los mismos Institutos o centros de Investigación, rotando solamente los nombres de los integrantes pertenecientes a esos Institutos y Centros y traspasándose del CONICET a la ANPCYT y viceversa, en un claro ejemplo antidemocrático, discriminatorio y partidista, con incidencia clara en el otorgamiento de subsidios y becas y reparto del dinero público” (investigador principal de ciencias biológicas y de la salud).

“Al menos en mi campo, Ciencias Sociales y Humanidades, que es el que conozco, institucionalmente se debería asegurar una auténtica representación federal en las comisiones asesoras y en la Junta de Calificaciones del CONICET. También, asegurar una adecuada renovación de los miembros de esas instancias evaluadoras, evitando la reiteración de nombres. Todo ello implica democratizar los modos de selección de las comisiones” (investigador principal de ciencias sociales y humanidades).

“Sería importante una mayor rotación de los miembros de las comisiones asesoras, ya que generalmente son un círculo de amigos que se van proponiendo alternativamente” (investigador principal de ciencias agrarias, ingenierías y materiales).

“Considero que las evaluaciones en comisión son actualmente sesgadas a los intereses de los integrantes de la comisión, tanto académicos como profesionales y de sus institutos de origen. Esto es particularmente así en disciplinas con comunidades comparativamente chicas. Muchas veces se califican informes, ingresos y promociones en función de esos intereses, con claras faltas de ética, con el fin de promover personal propio o amigos en desmedro de otros. En las renovaciones de las comisiones se perpetúan dichos intereses mediante la postulación de nuevos miembros afines” (investigador principal de ciencias exactas y naturales).

La selección de los evaluadores en general, y la de los miembros de los cuerpos colegiados en particular, fue un tema en el que los científicos pusieron mucho énfasis.Queda así evidenciada la brecha que existe entre la percepción de los investigadoresy lo que define la Ley de Ciencia, Tecnología e Innovación (en su artículo 23, incisod): “Instituir formas de selección de los evaluadores que garanticen su idoneidad e imparcialidad”.7

El paso inmediato en nuestro análisis para el relevamiento derivó en aspectos que indagan la forma de actuación de dichos pares evaluadores. Esto lo podemos observar desde dos enfoques: por una parte, qué es lo que perciben los encuestados respecto del efecto que puede tener esta dinámica de selección sobre la propia tarea del evaluador; y por otra parte, cómo consideran los investigadores la calidad y la transparencia de las evaluaciones.

La convocatoria de evaluadores a partir de un grupo acotado de candidatos, en un entorno de crecimiento permanente de los casos a evaluar, supone la ocurrencia de un primer efecto natural, la sobrecarga de trabajo. En esta línea, tanto en Campanario (2002) como en Albornoz (2003), encontramos argumentos que plantean una mirada crítica sobre el sistema de peer review, con especial acento en sus procesos de implementación. Sobre esta cuestión se consultó a los encuestados si consideran que hay sobrecarga de trabajo en pocos evaluadores y, para aquellos que sostienen que existe este problema, cuáles son los motivos de ello.

Tabla 8. Consideraciones sobre la sobrecarga de actividades en pocos evaluadores,según si fue evaluador

Gráfico 2. Consideraciones sobre las causas que provocan sobrecarga de trabajo

La convocatoria recurrente de los mismos evaluadores es la causa de sobrecarga de trabajo que más destacan los científicos. Esto deriva en una consecuencia directa, la fatiga que ello provoca en los pares, lo que a su vez podría afectar los resultados dela actividad de evaluación. Con el objetivo de indagar la percepción de los investigadores sobre este aspecto, se les consultó de forma expresa si ellos consideran que una elevada cantidad de casos asignados y la consecuente fatiga del evaluador podrían afectar la calidad de su trabajo.

Tabla 9. Opinión sobre si la sobrecarga de evaluaciones puede representar o no una fatiga tal para el científico que afecte la calidad de su evaluación

Tanto la cantidad de evaluadores disponibles como las convocatorias reiteradas de los mismos pares son considerados factores determinantes de la sobrecarga de trabajo y la fatiga. Por ende, de la calidad de las evaluaciones. Pero a todo ello también contribuye la cantidad de veces que se evalúa a un investigador, más precisamente cada cuánto tiempo se lo evalúa. En este sentido, es pertinente destacar los resultados de otra pregunta que explora la opinión de los científicos sobre la periodicidad de las evaluaciones.

Tabla 10. Opinión sobre periodicidad actual de las evaluaciones según la categoría

Los investigadores de las categorías que van de adjunto a superior consideran mayoritariamente que es correcta la periodicidad actual de las evaluaciones. Pero entre los asistentes, el 59,6% opina que son muy cortos los períodos actuales entre evaluaciones, que no deberían realizarse tan seguido. Esta categoría, la menor de la carrera, es la única en la que la evaluación de los informes se realiza todos los años, a diferencia del resto de los niveles, que son bianuales. Estas evaluaciones tan cercanas entre sí para los asistentes tienen cierta lógica si las analizamos en el marco de una carrera científica en la que aún estos investigadores no han obtenido total estabilidad, al menos desde lo que expresa la normativa (CONICET, 2017b).8

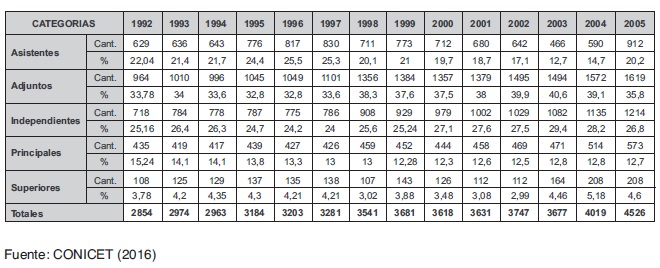

Como se refleja en la Tabla 11, el CONICET ha tenido históricamente una distribución de investigadores que no representaba una pirámide respecto del nivel de los científicos, como ocurre en la mayoría de las organizaciones con sus recursos humanos. La menor categoría de la carrera, los asistentes, siempre tuvo menos investigadores que la siguiente, los adjuntos. Esto ocurría por la cláusula de egreso que para los asistentes se incluye en el Estatuto de las carreras, donde se establece un límite de cinco años. En ese lapso, ya sea porque promocionaban a la clase de adjunto o porque quedaban fuera de la carrera, todos dejaban de ser asistentes. Sin embargo, en el ranscurso de la última década se ha suspendido la aplicación de esta cláusula, lo cual produjo un incremento sostenido en este conjunto de investigadores.

Tabla 11. Distribución de los investigadores del CONICET según categoría (1992-2005)

Tomando estas proporciones generales, en 2005 se evaluaba anualmente los informes del 60% del total de investigadores de la carrera (2700 casos sobre un total de 4526), todos los asistentes más la mitad del resto de las categorías. Con idéntico criterio y a partir del crecimiento de la menor categoría de la carrera científica, en 2016 ya se evaluaba al 70% del total (7000 casos sobre un total de 10.036).

Gráfico 3. Distribución de los investigadores del CONICET

Mientras los ingresos anuales a la carrera (que son la mayor parte en el nivel de asistentes) continúen siendo superiores a las promociones anuales hacia la categoría de adjuntos, el porcentaje de evaluaciones anuales continuará en aumento. Si a esto además le agregamos un crecimiento inercial de la masa global de investigadores, ese porcentaje creciente se aplicará cada año sobre un total que también está en constante expansión. Todo lo cual presagia un único escenario: el colapso del sistema de evaluación de los informes. Evaluación que, por otra parte, tiene una altísima tasa de aprobaciones (superior al 95%), motivo que también pone en discusión la pertinencia de este proceso, o al menos la de tan corta periodicidad para la menor categoría de la carrera científica, que hoy parece tener la misma estabilidad que el resto.

Lo que surge de este análisis es un aspecto directamente relacionado con los procesos de gestión. Sin entrar en ningún tipo de valoración sobre la conveniencia de haber suspendido la cláusula de exclusión de los asistentes, lo que se observa es que se trató de una medida aislada, probablemente como respuesta a una situación coyuntural que debía ser resuelta. Pero lo que parece haber estado ausente es una mirada integradora que, desde la planificación, sea capaz de articular una batería de medidas que logren atemperar el impacto producido sobre el sistema de evaluación en su conjunto.

Continuando el análisis sobre la cantidad de evaluaciones, se consultó a los investigadores cómo consideraban más adecuado que se realicen los procesos de evaluaciones académicas de informes y promociones: si en forma separada como se realiza actualmente o de manera unificada en un solo proceso. Más de la mitad de los encuestados se manifestó a favor de la unificación de estos procesos (52,8%). Esta tendencia se mantiene en todas las categorías de la carrera, en contraposición a un 38,7% que expresó que deben mantenerse separadas (el 8,5% restante respondió NS/NC).9 Lo que subyace en la visión de la mayoría de los científicos no es sólo un tema de procedimientos que parece profundizar la aspereza de la tarea de los pares evaluadores. También puede inferirse de sus respuestas la necesidad de una mirada más integral, de conjunto, que permita valorar en una única instancia toda la actividad desplegada por el investigador. Este análisis transversal podría luego derivar en una recomendación -o no- de aprobación de un informe o de una promoción. También surge un elemento diferenciador en esta pregunta, el resultado de las respuestas de los representantes del área de ciencias Sociales y humanidades (CSH).

Gráfico 4. Opiniones sobre la unificación o no de las evaluaciones de informes y de promociones, según área de conocimiento

Cuando cruzamos la variable de esta pregunta con el área de conocimiento a la que pertenece el encuestado, podemos observar que, en las CSH, el 43,2% considera que deben unificarse las evaluaciones de informes y promociones, proporción que es superada por el 46,3% de la misma área que opina que deben mantenerse separadas. Si bien los porcentajes son muy cercanos, este cambio entre el primero y el segundo lugar marca una diferencia con las restantes áreas. En otras preguntas del relevamiento también surgieron algunas tendencias diferenciadoras de las CSH respecto de los demás grupos disciplinares. Podemos interpretar esto como indicios que fortalecen la postura que sostiene la existencia de una diferente práctica, cultura, idiosincrasia o forma de producción y de evaluación entre lo que tradicionalmente se denominan “ciencias duras” y “ciencias blandas”.

Al avanzar sobre otros aspectos de la labor de los pares evaluadores, expusimos también dos temas que surgieron tanto de la bibliografía como de las entrevistas a informantes clave: 1) si la labor de los pares debe ser rentada; y 2) si el acceso a información sensible puede resultar en algún tipo de aprovechamiento o uso indebido por parte del evaluador. Sobre el primer tema, los investigadores del CONICET opinaron en mayor proporción (49,9%) que no debe ser rentada, mientras que el 36,2% cree que sí debe serlo. Sin embargo, esta respuesta global tiene también sus matices cuando se analiza por cada área de conocimiento. Los valores anteriores se mantienen cercanos a los que surgen para las ciencias agrarias e ingenierías, biológicas y de la salud, y para las exactas y naturales, pero nuevamente se diferencian en las ciencias sociales y humanidades, donde la opción más respondida fue que sí debe ser rentada (46,9%), en comparación del 39,6% de la misma área que opina que no debe ser rentada. De esta manera, las CSH continúan dando pautas de una mirada diferenciadora, lo que de alguna forma pone de relieve la necesidad de estar atentos desde las instituciones a una posible dinámica de evaluación con rasgos particulares en este campo disciplinar.

Luego, sobre el tema del posible uso indebido de la información a la que accede el evaluador, los investigadores perciben lo que describe en la Tabla 12.

Tabla 12. Percepción sobre el uso indebido de la información que se evalúa, según si fue o no evaluador

Se verifica un equilibrio entre quienes actuaron o lo hacen actualmente en el rol de evaluador: el 38,6% considera que sí puede existir aprovechamiento de esa información, mientras que el 38,7% cree lo contrario (el 22,7% NS/NC). En este caso dicha paridad no puede considerarse como una simple diferencia de opiniones. Estas cifras deben preocupar porque surgen de los propios evaluadores, pero se profundizan aún más cuando sobre la misma variable se miden los resultados de las opiniones de los científicos que todavía no han actuado como evaluadores, esto es: cuando se atiende a la visión externa de quienes son evaluados pero no forman parte del proceso. En este último grupo, el 45,1% considera que puede haber uso indebido de la información, frente al 27,6% que no considera posible dicha situación. Dada la sensibilidad de este tema, es prudente tomar estas cifras como indicadores de una percepción, pero ello no lo hace menos preocupante. De lo que no cabe duda es que estos valores debieran significar una luz de alerta para las instancias de gestión. Algunos investigadores lo expresaban de la siguiente manera:

“También he constatado en ocasiones rechazos de proyectos de investigación cuyos contenidos aparecen en proyectos de miembros de la comisión o integrantes de sus grupos” (investigador principal de ciencias exactas y naturales).

“Las evaluaciones deben salir de la cofradía de los miembros que perpetuamente son evaluadores porque se evalúan entre ellos y dejan afuera los que no son de su ambiente, o le roban las ideas a los proyectos que no aprueban. Yo ya estoy jubilada y puedo decir muchas cosas, una de ellas es que mi paso por CONICET fue muy duro porque como mujer, no fui sumisa con un investigador que estaba en el Directorio. Mi mayor proyecto de investigación y transferencia de tecnología BID-Agencia de Promoción Científica fue aprobado y realizado por fuera de la evaluación de CONICET y a partir de ese entonces nunca más pedí promoción o subsidio a CONICET y logré mucho más crédito como investigadora en el exterior y me siento muy feliz de haberlo logrado” (investigadora independiente de ciencias agrarias, ingenierías y materiales).

“Los evaluadores considerados “pares”, en muchos casos, no lo son. Los miembros de las Comisiones se designan a dedo, y en muchos casos son personas con procesos pendientes, por su dudosa actuación científica” (investigador principal de ciencias exactas y naturales).

Otra polémica frecuente, en lo que respecta a la selección de los pares evaluadores, es si debe convocarse a científicos de otros países. Los debates parecen pendular entre, por una parte, el riesgo de valorar nuestra ciencia a partir de criterios que no son propios, que representan sólo a los intereses de las investigaciones de los países centrales; y por otra parte, el riesgo de aislarnos en una ciencia local que sólo promueva desarrollos que siempre irán a la zaga de las investigaciones de punta que lleva adelante la corriente principal de la ciencia. Sobre la participación de evaluadores de otros países, el 74,8% de los encuestados opina que sí deben hacerlo en nuestros procesos de evaluación, mientras que el 14,9% opina que no deben participar (el 10% restante NS/NC). Sobre el nivel de participación de los evaluadores extranjeros, entre los más de 1200 científicos que consideraron que sí deben hacerlo, la proporción más elegida es la que manifestaron 387 encuestados, expresando que en un proceso de evaluación el 30% de los pares convocados debería ser de otros países.

La necesidad de incorporar evaluadores de otros países es una perspectiva muy clara para la mayoría de los científicos. Se trata de un elemento central de la política de ciencia y tecnología; no es sólo una medida de apertura y de fortalecimiento de la transparencia: es una decisión que lograría articular nuestros procesos evaluación con los mecanismos y la rigurosidad que se aplica en el contexto internacional. Además, incorporar una proporción de esta envergadura de evaluadores del exterior (30%) implica la necesidad de un replanteo desde la gestión y respecto de la asignación de recursos para cumplir con esta meta.

Gráfico 5. Opinión sobre el nivel de participación que deberían tener los evaluadores de otros países en nuestro sistema de evaluación

Ingresando ya en lo que es la tarea propia de valoración del par, diversos autores abordan el tema de las replicaciones, en relación a cómo son considerados estos trabajos al momento de ser evaluados.10 Campanario (2002: 275) alude a este aspecto como uno de los posibles sesgos en la instancia de evaluación; una perspectiva que también emergió en algunas de las entrevistas a informantes claves que realizamos para este trabajo. Por esta razón, se consideró relevante conocer también la percepción de los encuestados al respecto.

El 51,3% del total de científicos participantes cree que los evaluadores consideran a las replicaciones de menor nivel que el de una investigación original. Menos de la mitad de este porcentaje, el 23,5%, opina que son consideradas de igual forma. Estas proporciones se mantienen en un rango similar entre quienes han sido evaluadores y quienes aún no ejercieron dicho rol. Pero nuevamente la diferencia se presenta al observar las respuestas según las áreas del conocimiento, más específicamente entre las CSH y las demás. En las ciencias biológicas y de la salud, por ejemplo, se destaca la percepción de menor reconocimiento de las replicaciones: más de un 65% de estos investigadores cree que son consideradas de menor nivel, frente a un 18,8% que interpreta que son valoradas de igual forma. También es significativo en este sector de la ciencia el alto nivel de respuestas efectivas, sólo el 14,1% optó por la opción NS/NC, evidenciando así el importante grado de incidencia del tema en sus disciplinas. En oposición a ello, en la única área del conocimiento en que se invierten los valores de esta pregunta es la de las CSH, donde los NS/NC alcanzan al 38,5% de las respuestas, lo que expone la baja prioridad del tema para este conglomerado de disciplinas.

Tabla 13. Percepción sobre cómo se consideran las replicaciones al ser evaluadas, según área de conocimiento

Otro aspecto también indagado sobre las líneas de investigación, es la opinión sobre la postura de los evaluadores frente a desarrollos que se orientan a temas más tradicionales que otros. Se preguntó si existe algún tipo de sesgo conservador (Albornoz, 2003), una tendencia o costumbre en las decisiones de los pares evaluadores que los lleve a valorar mejor a las investigaciones en temas establecidos dentro del paradigma vigente, en detrimento de temáticas nuevas e innovadoras (menos ortodoxas). La opción más votada corresponde a 706 investigadores (42,7%) que consideran que sí existe una tendencia más favorable que privilegia los temas tradicionales, en contraposición con los 588 casos (35,6%) que opinan lo contrario. Una vez más, la mayor diferencia porcentual entre ambas opciones está en las CSH.

Tabla 14. Opinión sobre si existe una valoración más favorable para los temas tradicionales frente a los menos ortodoxos

Finalizando este módulo del relevamiento, se consultó sobre el nivel de cumplimiento de los criterios de evaluación. Más allá de las dudas expresadas sobre el proceso previo de definición de los criterios, es claro que una vez que el evaluador recibe un caso debe aplicarlos. Pero la forma de hacerlo también es un tema que genera controversias. Entre quienes actuaron como evaluadores, más del 50% observa que se hacen algunas o muchas excepciones. Sólo el 21,1% del mismo grupo cree que se aplican de igual forma en todos los casos, sin excepción. Pero entre quienes no han actuado aún como evaluadores la percepción es mucho más escéptica: sólo el 8,6% creen que se aplican tal como fueron definidos.

Tabla 15. Opinión sobre la forma de aplicar los criterios de evaluación

El tema de los criterios de evaluación es claramente un aspecto muy sensible para los científicos. Un investigador independiente del área de CSH expresó en la encuesta: “La evaluación en CyT está obvia y estrictamente relacionada con la ideología y política científica sobre la que se sustenta. Al no haber clara definición y acuerdo sobre ellas, el sistema de evaluación se convierte en una mezcla perversa de criterios y contra criterios disfrazados y ocultos que impiden una labor honesta y coherente”.

Todo lo expuesto hasta esta instancia sobre los criterios de evaluación es sólo una parte de la complejidad del tema. Otra de las aristas significativas que complementan este análisis es lo que hace a la difusión de esos criterios. El conocimiento de los parámetros de evaluación por parte de quien será evaluado es algo fundamental. La difusión de estos criterios en forma clara y previa a una presentación es tan importante como su correcta definición y aplicación.11 Todo ello define un aspecto medular del sistema: su transparencia.12 Para relevar la opinión de los científicos respecto de este tema, se les consultó a los encuestados si, cuando realizan una presentación para ser evaluada por el CONICET, consideran que los criterios de esa evaluación están claramente publicados antes de su presentación. En la Tabla 16 y el Gráfico 6 se describen las proporciones de cada respuesta.

Tabla 16. Opinión sobre si el CONICET publica los criterios de evaluación

Gráfico 6. Opinión sobre si el CONICET publica claramente los criterios de evaluación,según la categoría

Mayoritariamente, un 71,5% de los 1654 encuestados opinó que no están claramente publicados. Sólo un 24,9% cree sí están publicados y el 3,6% NS/NC. La baja tasa de NS/NC indica que se trata de un tópico de especial interés para los investigadores. En este sentido, muchos encuestados incluyeron manifestaciones como las siguientes:13

“En mi opinión, los criterios de evaluación no son claros y muchos investigadores y becarios los desconocen. Se conocen con más detalle cuando una persona cercana al área laboral integra alguna Comisión de evaluación y trascienden los criterios” (investigador principal de ciencias agrarias, ingenierías y materiales).

“(...) transparencia y publicación de los criterios de evaluación con anterioridad a la fecha de cierre de presentación a una instancia de evaluación y promoción. Esto sería útil para establecer pisos mínimos de requisitos en cada instancia que sean conocidos por los postulantes a priori del concurso” (investigador principal de ciencias biológicas y de la salud).

“Considero dos aspectos que podrían mejorarse. El primero es la transparencia de las evaluaciones, a través de la publicación previa y detallada de los criterios a utilizarse en las ellas (sobre todo en las de asignaciones de becas o ingresos)” (investigador independiente de ciencias exactas y naturales).

“Los criterios de evaluación son demasiado generales y cada comisión puede hacer prácticamente lo que se le antoja. Tanto en mi función de investigador como en la de evaluador nunca sé qué se me va a evaluar y qué puede ser importante para la comisión que recibirá mi informe o evaluación. En ningún informe, jamás, han emitido opinión acerca de mis resultados de investigación, entonces uno sólo sabe que han sido satisfactorios, pero no qué significa eso en el contexto de las políticas del CONICET. Además, algo que me parece el colmo de la arbitrariedad es que cada comisión pueda rever los criterios de la anterior y que, en todos los casos, estos criterios no se hagan públicos” (investigador independiente de ciencias sociales y humanidades).

Al tratar de identificar un correlato entre estas opiniones y lo que expone públicamente el organismo en la información que presenta en cada convocatoria, encontramos que, bajo el concepto de “Sistema de evaluación”, se describen todas las instancias de este proceso. Sin embargo, a la hora de buscar esos criterios de evaluación, que más del 70% de los investigadores dice que no están publicados, no se encuentra un detalle claro. En la información oficial se presenta la conformación de cuerpos colegiados, del banco de pares, de los circuitos por objetos de evaluación y -como soporte de gestión a todo esto- casi una decena de manuales muy detallados para la carga de datos en lo que denominan Sistema Integral de Gestión y Evaluación (SIGEVA), una aplicación informática. Pero sobre los criterios, sobre la forma de valorar esta información en cada convocatoria en particular, sobre el peso asignado a cada ítem, no existe referencia alguna.

En este grupo de preguntas de la encuesta se observan distintos temas que surgen de manera reiterada. Pero entre las respuestas y opiniones libres de los investigadores se comienza a delinear un argumento central que cobra mayor densidad, vinculado con todo aquello que hace a la transparencia de los procesos de evaluación. En este ámbito identificamos dos aspectos que generan tensión entre los científicos: por una parte, todo lo relacionado a la conformación de los cuerpos colegiados de evaluación, principalmente las comisiones asesoras; y por otra, la falta de una clara definición y publicación de los criterios de evaluación para cada convocatoria. Lo que subyace también en las manifestaciones relevadas es la preocupación por un permanente cambio de reglas. Se identifica una fuerte sensación de arbitrariedad que parece operar, desde la perspectiva de los científicos, a favor de un proceso maleable en beneficio de unos pocos. Como sintetiza el siguiente testimonio:

“Hay mucho amiguismo y enemiguismo, se utilizan las comisiones / evaluaciones para ayudar a amigos y complicar a otros. Por ejemplo, en evaluaciones detecté fraude en casos en que se mentía sobre las publicaciones, que no existían, y todo siguió igual, los investigadores recibiendo subsidios y promocionando en carrera. La ciencia es parte de la sociedad, el Clientelismo está muy arraigado en nuestra cultura” (investigador principal de ciencias agrarias, ingenierías y materiales).

3.2. Incidencia de los indicadores bibliométricos en las prácticas de evaluación

A partir de las distintas fuentes consultadas observamos que, dependiendo del área disciplinar de la que se trate, un trabajo científico puede ser considerado de mayor prestigio en función de la revista donde se lo publica, antes que por su propio contenido. En algunas ocasiones, los parámetros bibliométricos como el factor de impacto son interpretados como “reglas de oro” en el momento de evaluar a un investigador.14 Por esto, uno de los interrogantes que destacamos es si la evaluación pasó de estar basada en valoraciones de expertos a depender de este tipo de métricas. En base a ello, intentamos ver si se corroboran estas interpretaciones indagando cómo es la mirada de los investigadores respecto de la incidencia de los indicadores bibliométricos en las evaluaciones.15

Consultados acerca de cómo consideran que es el uso actual de estos indicadores, una gran mayoría de los encuestados -el 77,8%- opina que en la actualidad se utilizan principalmente los indicadores que provienen de bases de datos y clasificaciones internacionales.

Tabla 17. Opinión sobre si existe equilibrio en el uso de indicadores bibliométricos internacionales y locales en los procesos de evaluación científica

Discriminando las respuestas por área de conocimiento, ese porcentaje se incrementa a valores que van del 85 al 90% para todas las disciplinas, menos para las correspondientes a las CSH. En este sector también opinan mayoritariamente que hoy se usan estos índices internacionales con mayor asiduidad que otros, pero las magnitudes de cada respuesta son más homogéneas, creciendo los NS/NC en cantidades que duplican a dicha opción en las otras áreas. Esta diferencia podría estar indicando que, para las CSH, la discusión no pasa por el tipo de indicadores, sino que es el propio sistema de indización el que transita por canales distintos de los que habitualmente pueden utilizar las publicaciones de esta área del conocimiento. Observa un científico de esta área que:

“Los índices bibliométricos no registran la publicación de libros y de capítulos de libros -que son publicaciones muy importantes en nuestra disciplina-, por lo tanto no pueden ser los únicos criterios a tener en cuenta. El factor de impacto, precisamente, no registra el impacto de y en libros y partes de libros, por lo que no puede ser tomado como un criterio de peso en nuestra evaluación. El impacto de nuestras publicaciones no es inmediato, se extiende a lo largo de muchos años, no es cuantificable con los medios de medición que se utilizan en la actualidad, que toman casi exclusivamente el inglés como lengua de publicación. Estos sólo se deben tomar como un elemento más a considerar” (investigador independiente de ciencias sociales y humanidades).

Estos argumentos le dan cuerpo a esa diferenciación que surge de las CSH en los distintos ámbitos de la evaluación que venimos describiendo en páginas previas. Las especificidades de las publicaciones en esta área también dan cuenta de ello. Una importante y alentadora iniciativa de estudio de este tema se produjo en 2013. En el ámbito del CONICET, en uno de sus institutos de investigación -el Centro de Estudios e Investigaciones Laborales (CEIL)- se conformó la denominada Comisión Interinstitucional de Elaboración de Criterios de Evaluación para las Humanidades y las Ciencias Sociales (CIECEHCS). Este cuerpo colegiado estuvo compuesto por investigadores de diferentes instituciones y produjo, a modo de recomendaciones, un documento sobre “Criterios de evaluación de la producción científica de las Humanidades y Ciencias Sociales”. La misma comisión organizó una jornada para profundizar el análisis en estos temas que atañen a las ciencias sociales y a las humanidades.16 En el debate realizado en base a los ejes tratados por la CIECEHCS, se destacaban tres ámbitos en particular:

1. ¿Cómo es y cómo debiera ser considerada la especificidad en las ciencias sociales y humanas en el sistema de evaluación?

2. ¿Cómo evalúa los actuales criterios de jerarquización y ponderación de los componentes de informes, proyectos, solicitudes de promoción? ¿Los reformularía? ¿Cómo?

3. ¿Qué condiciones debería reunir un postulante para acceder a beca y a carrera de investigador en cualquiera de sus categorías?

Más allá de las consideraciones específicas que sobre cada uno de estos aspectos fueron vertidas en la discusión, el punto central es la apertura de un espacio de reflexión que contenga este debate. Si bien en la posterior actualización del sistema de evaluación del CONICET -en febrero de 2016- no se encuentran referencias significativas a la incorporación de las recomendaciones de la CIECEHCS, es importante que desde la institución se promuevan estas instancias de análisis sobre sus procesos de evaluación.

Avanzando en el relevamiento, se consultó a los científicos si consideran que el uso de indicadores bibliométricos (de todo tipo) tiene demasiado peso respecto de la totalidad de criterios y perspectivas de evaluación actual, y si creen que el uso de indicadores como el factor de impacto puede tener alguna incidencia en el desarrollo de la ciencia y la tecnología local. Sobre el primer aspecto, casi las tres cuartas partes de los encuestados (72.5%) interpretan que en la actualidad los indicadores bibliométricos sí tienen demasiado peso en los procesos de evaluación frente a otros aspectos que se deben evaluar. Con algunos matices no muy significativos, esta tendencia se reitera en todas las áreas del conocimiento. En cuanto a la incidencia del uso de estos indicadores en la ciencia y la tecnología local, el 68,4% de los encuestados opina que sí existe, que de alguna manera afecta al desarrollo científico de nuestros países. Este porcentaje representa la opinión de 1131 investigadores, grupo al que se le preguntó además en qué forma consideran que afecta esta incidencia. Pudiendo seleccionar varias opciones por investigador, los tres impactos que más observan los científicos sobre nuestro desarrollo regional son: la reorientación de temas de investigaciones locales (67,4% de los 1131 investigadores); el fraccionamiento de publicaciones para aumentar su número (60,3% de los 1131 investigadores); y la afectación del desarrollo de las revistas científicas locales (59,0% de los 1131 investigadores).

Se puede interpretar que tanto la reorientación de temas de investigación como el fraccionamiento de publicaciones son prácticas a las que los investigadores adhieren para aumentar sus probabilidades de publicación y las cantidades de las publicaciones, como respuesta a los requisitos de evaluación. Respecto del desarrollo de las revistas locales, se consultó además sobre la posibilidad de la existencia de sesgos en las evaluaciones que pudieran responder a algún tipo de afinidad con las editoriales internacionales, las mismas que califican las publicaciones científicas.

Tabla 18. Opinión sobre si existe algún sesgo o incidencia de las principales editoriales internacionales en los procesos de evaluación científica

Las opiniones en esta variable se encuentran muy parejas, en torno al 40%, con una leve ventaja para aquellos que consideran que no existe dicho sesgo. Por ello, más que una afinidad con las editoriales extranjeras podríamos interpretar, nuevamente, la existencia de un reacomodamiento para adaptarse a lo que inducen las prácticas de evaluación. Esto significa entrar en los primeros cuartiles o deciles de las nóminas de factores de impacto que se usan como parámetro en las distintas comisiones disciplinares.

Otro elemento que articula en forma directa a los indicadores bibliométricos con las instancias de evaluación es la forma en que los cuerpos colegiados definen la importancia de una publicación en base al medio en el que fue publicada. El 61,5% de los encuestados está de acuerdo en que a la hora de valorar la publicación de un investigador en base a escalas de revistas científicas, sean los miembros de cada disciplina los que interpreten el nivel de la publicación. Lo mismo se verifica cuando el 49% de los encuestados considera que los pares evaluadores de las disciplinas deben ser también quienes categoricen a las revistas de su área, frente a un reducido 8,6% que se inclina por dejar esa tarea en manos del más alto nivel de gestión institucional. Estas preguntas se orientaban a indagar la opinión sobre una mirada integral, por ejemplo, a nivel del directorio del organismo. Esta necesidad de una visión más homogénea de los criterios entre las distintas comisiones disciplinares, tanto de la misma área del conocimiento como en general de todas las áreas, es declarada expresamente por varios investigadores:

“ No hay un criterio uniforme entre comisiones evaluadoras. Un mismo candidato puede ingresar a CIC o promocionar en una comisión, y no hacerlo en otra” (investigador independiente de ciencias biológicas y de la salud).

“Creo que se deben homogenizar más los criterios de evaluación entre comisiones de CONICET por ejemplo” (investigador independiente de ciencias agrarias, ingenierías y materiales). “Unificar criterios entre Comisiones Asesoras y Junta de Calificación” (investigador independiente de ciencias exactas y naturales). “Unificar criterios entre comisiones evaluadoras de disciplinas cercanas” (investigador principal de ciencias biológicas y de la salud).

“Consensuar criterios entre comisiones de temáticas afines” (investigador principal de ciencias biológicas y de la salud).

Ahora bien, este reclamo de consenso para no tener un sistema con criterios tan dispares hay que evaluarlo, al menos, en el marco cada área del conocimiento. Precisamente en el caso de los indicadores bibliométricos, una mirada integral que no contemple las formas y la cultura de publicación de cada disciplina podría acarrear más problemas que soluciones. Uno de los riesgos que suele identificarse en el uso de mediciones como el factor de impacto es, por ejemplo, el establecimiento de escalas de posicionamiento general y no por rama de especialidades. Sobre este aspecto, el coordinador de la Red Iberoamericana de Indicadores de Ciencia y Tecnología (RICYT) expresó la importancia de conocer primero la dinámica y las formas de publicación de las distintas disciplinas para poder comprender acabadamente qué representa el indicador. Las comparaciones, añade el experto, no deben realizarse entre parámetros de publicaciones de científicos de distintas disciplinas, sino entre pares de la misma especialidad, con las mismas reglas de juego. Luego sí, el factor de impacto puede resultar un parámetro útil como una herramienta más en el proceso de evaluación. Todo análisis sobre el uso de los indicadores surge ya desde la teoría como un ámbito de debate permanente, discusión que se corrobora en las distintas posturas manifestadas por los encuestados. Pero la mayor tensión que suscita el tema no sólo responde a cómo se realizan estas mediciones, sino también al uso que se hace de estos valores. Existen posturas antagónicas sobre qué se quiere medir y cómo se lo mide. Sin embargo, a la hora de articular esta herramienta en una práctica de evaluación, el centro de la polémica parece girar alrededor de la entronización que muchos procesos de evaluación de la ciencia y la tecnología hacen de estos índices.

El debate sobre el uso de métricas basadas en revistas, como el factor de impacto, parece tener un punto de anclaje en la determinación de su validez para una evaluación en particular. Se trata de dirimir si estas mediciones son capaces de sustituir la calidad propia del artículo individual. La primera recomendación de la Declaración de San Francisco (2012) es determinante en este sentido: promueve claramente la no utilización del factor de impacto. Además, en su iniciativa número 15, este acuerdo insta a los participantes de las comisiones evaluadoras a basarse en los contenidos científicos. Por su parte, también el Manifiesto de Leiden (2015) codifica en sus diez principios las pautas necesarias para evitar que la información cuantitativa se convierta en un objetivo en sí misma.17 Estas directrices buscan un equilibrio entre esas métricas y la valoración cualitativa de los expertos que debe primar en toda evaluación. Establece que el desempeño debe ser medido de acuerdo con las misiones de investigación de la institución, del grupo o del investigador individual, a la vez que advierte sobre la necesidad de transparencia en los procesos de recopilación de datos para las evaluaciones. Sin embargo, frente a estos posicionamientos, que buscan revalorizar la producción puntual por sobre las mediciones abstractas del medio de publicación, cabe preguntarnos si en el contexto actual los pares evaluadores estarán dispuestos a leer en profundidad, por ejemplo, entre tres y cinco artículos científicos de cada evaluado. Si se convoca siempre a unos pocos, si tienen sobrecarga de asignaciones, si las excusaciones están al tope de las problemáticas en las convocatorias, la revisión de artículos parece entonces tornarse un camino árido desde el punto de vista de la gestión de este proceso. Todo ello además de la responsabilidad adicional para el evaluador de tener que expedirse sobre la calidad de una o más publicaciones en particular. Por este motivo, es preciso abordar cambios bien planificados e integrales antes que tomar buenas medidas aisladas que pueden generar efectos colaterales adversos.

Este análisis nos da cuenta del peso y la incidencia de la gestión de un sistema de evaluación sobre el propio sistema, pues ambos no son campos excluyentes. Sin emitir juicios de valor sobre la conveniencia del uso de mediciones como el factor de impacto, mientras para algunos no representan el verdadero producto del trabajo individual del científico, para otros son una herramienta de gestión y un parámetro de referencia muy valioso, que permite hacer frente a evaluaciones que se cuentan por miles. En base a este argumento, también preguntamos en la encuesta si los científicos consideran que estas mediciones son un elemento válido para el manejo de la masividad de los casos. Dos terceras partes (66,8%) de los encuestados consideraron que los indicadores bibliométricos sí son útiles en dicho sentido. Pero, al mismo tiempo, los científicos también expresaban, en un 70,7%, que es conveniente utilizar otro criterio que los complemente. Una lectura más amplia permitiría interpretar que estas manifestaciones se orientan hacia la búsqueda de equilibrio entre la necesidad de gestionar un proceso masivo, por una parte, y la de evitar una centralidad excesiva de mediciones como el factor de impacto en las prácticas de evaluación de la ciencia y la tecnología, por otra.

“La calidad de la producción y publicación de resultados de investigación quedan supeditadas a una lógica de indicadores bibliómetricos que no dicen nada acerca de la rigurosidad de la labor científica. Una parte significativa no valorada sobre todo en el caso de las ciencias sociales y humanas, es el esfuerzo y el trabajo colectivo llevado adelante para la publicación de libros, o capítulos de libros que hoy son absolutamente desvalorizados en todas las etapas de evaluación” (investigador adjunto de ciencias sociales y humanidades).

3.3. El currículum vitae (CV) como herramienta para la evaluación

Tomando como sustento los estudios sobre los ciclos de vida (Dietz et al., 2000), y en el enfoque diferenciador que brinda la mirada transversal de la trayectoria de una persona, entendemos que los CV son un acervo de información que debería tener un lugar relevante en el momento de evaluar el desarrollo de la carrea científica de un individuo. Esta consideración es acompañada por el 81,9% de encuestados.

Sobre esta fuente algunos autores (Jaramillo, Lopera y Albán, 2008) sostienen una postura de mayor cautela frente al nivel de veracidad de este tipo de información auto- reportada. Dado que es el propio investigador quien diseña su CV, estos expertos advierten que el contenido podría estar sujeto a sesgos y valoraciones particulares. Pero los avances logrados los últimos años en la conceptualización y en la estructuración de los CV actuarían hoy como un atenuante de posibles ambigüedades en los datos, generando así condiciones que tiendan a un registro más preciso de la información. Esta perspectiva puede apoyarse en las respuestas del 69,1% de los científicos, que opinaron que la información de los CV no es ni sesgada ni poco confiable para un proceso de evaluación. No obstante, hubo en la encuesta algunos comentarios aislados -no en cantidad significativa- que se expresaron de manera concordante respecto a las particularidades que mencionaban Jaramillo, Lopera y Albán (2008). Si bien las mejoras en los sistemas de registro logran filtrar gran parte de los posibles errores por parte del investigador al cargar su CV, parece aún existir cierta duda latente en algunos evaluadores sobre la exactitud de la información que deliberadamente registra el postulante.

“El tema de que los criterios no sean explícitos y públicos siempre es complicado, pero por otro lado los investigadores somos artistas en amoldar nuestros CVs/solicitudes a los criterios (públicos o no), con lo cual no estoy seguro de que eso aporte. De hecho en los CVs se ve con claridad que un mismo trabajo científico es consignado por una persona como artículo en revista, y por su co-autor como capítulo de libro o en evento científico ¿cómo puede ser? esto ocurre muchísimo y hace dudar de la honestidad de quienes solicitan algo y consignan ‘erróneamente’ esa información” (investigador principal de ciencias agrarias, ingenierías y materiales).

En otra pregunta sobre el tema, relevamos la opinión respecto del formato que se utiliza para el registro del modelo conceptual estandarizado de las hojas de vida. Específicamente, si consideraban que existe a nivel nacional una buena metodología de registro unificado para los CV, destacando la posibilidad de ingresar la información en un único repositorio. Y, en caso de considerar que sí existe esa metodología, se preguntó cuál era a su entender ese sistema de registro unificado nacional.

Tabla 19. Opinión sobre si existe a nivel nacional un registro unificado del CV

Tabla 20. Opinión sobre cuál es a nivel nacional la metodología o el sistema de registro unificado del CV

Sobre la existencia o no de este tipo de registro, las respuestas estuvieron divididas. Luego, para relevar la opinión sobre cuál consideran que es esa metodología, se agregó una pregunta de respuesta abierta. Pero las opiniones de los científicos se polarizaron entre dos opciones: 1) el CVar (Sistema de CV del Ministerio de Ciencia, Tecnología e Innovación Productiva); y 2) el SIGEVA (Sistema del CONICET). Sobre los 774 investigadores que respondieron que existe una metodología de registro a nivel nacional, el 50,9% considera que se trata del CVar, el 34,1% entiende que es el SIGEVA y el 13,44% menciona a ambos sistemas a la vez.18

Una división tan pareja entre las dos aplicaciones estaría indicando la falta de una comunicación precisa para los investigadores. La forma de relevar, dónde se registra y quién coordina los procesos de guarda de la información de nuestros recursos humanos en ciencia y tecnología, es un tema que no parece contar a nivel de gestión con un consenso mayoritario. En caso de existir algún tipo de consenso, éste no es percibido con claridad por toda la comunidad de investigación.19 Luego del registro, la manera en que se comparta la información entre las instituciones gestoras que forman parte del sistema, es otro espacio para el análisis. Pero sobre la identificación que hacen los investigadores respecto de cuál es el sistema de registro unificado a nivel nacional, se observa una falta de coordinación y de comunicación al usuario que debiera ser resuelta desde los niveles de gestión. A la vista de los investigadores, de todas las instituciones, la carga de su CV debería realizarse por una única ventanilla. Cuevas Badallo y López Cerezo (2009: 38-39), en una revisión del sector de ciencia y tecnología en España, destacaban que ya a inicios de los años 80 desde el Ministerio de Educación y Ciencia español se identificaba como una de las principales deficiencias de su ámbito de investigación a la “descoordinación entre las distintas instituciones que tenían alguna competencia en la I+D”. Hoy, los científicos de nuestro país parecen verse reflejados en un espejo que atrasa más de tres décadas.

Este debate no trata de establecer la calidad técnica de una propuesta o de la otra; está descontado que la capacidad profesional para el desarrollo de aplicaciones de buen nivel no falta en ninguna de estas instituciones. Lo que se pone de relieve es la escasa coordinación para llevar más certidumbre al personal científico que debe registrar no poca información. Un indicio de esta necesaria articulación se encuentra en una funcionalidad de ambos sistemas que parece haber considerado en algún momento la unificación del registro. Existe un proceso automático para transferir información de una aplicación a la otra. Sin embargo, llegado el momento de hacer uso de esta funcionalidad, no se verifica que sea una solución eficiente a un problema que para el investigador sigue estando presente, la carga duplicada de información en distintos sistemas.

“Finalmente, es necesario se unifiquen las bases de datos, teniendo en cuenta una encuesta a todo el personal de ciencia y técnica, que son los que padecen o padecieron las bases PUBAR, CVLaC, SIGEVA, diversas bases para las categorizaciones, CVAr.. Cuánto tiempo perdido en estas bases..! ¡ Cuánto tiempo perdido por problemas de servidores que no funcionan!” (investigador principal de ciencias sociales y humanidades).

“La unificación en el armado y presentacion del CV para todas las instituciones de CyT a nivel Nacional (verdadero sistema único)” (investigador independiente de ciencias biológicas y de la salud).

“Sobre SIGEVA vs. CVAR: qué esperamos para tener un solo CV nacional. Para qué sirve el MINCYT si es incapaz de lograr eso tan básico” (investigador independiente de ciencias sociales y humanidades).

“Que la base de datos de CVs sea nacional y unica y que no haya bases de datos por organismos y facultades en las que se deba replicar la información” (investigador adjunto de ciencias exactas y naturales).

“Respecto de los sistemas de CV debería existir uno solo: o CVar o SIGEVA y evitar los engorros de duplicación de información por ejemplo” (investigador independiente de ciencias sociales y humanidades).

Para completar esta perspectiva respecto de la metodología de carga de los CV, se consultó si se consideraba que el registro de esta currícula es reiterativo en cada institución convocante que debe realizar una evaluación determinada. En línea con las opiniones previas, dos tercios de los 1654 encuestados creen que sí es reiterativo este registro.

Tabla 21. Opinión sobre si el registro del CV es reiterativo en cada institución convocante, según si fue evaluador

En su conjunto, el tema de los CV de los investigadores no es un elemento nuevo en el marco de la dinámica de la ciencia y la tecnología. No lo es en cuanto a la evaluación ni respecto de las políticas científicas a nivel nacional. Los sistemas de currículum han sido tema de análisis en distintos países y ha pasado por diferentes etapas en todos ellos (D’Onofrio, 2009; Jaramillo et al., 2008). En la Argentina, la necesidad de contar con un registro unificado de esta información se vieneplanteando, al menos, desde fines de la década de los años 90. Durante mucho tiempo, el aspecto tecnológico fue lo que primó como principal obstáculo para avanzar en propuestas sólidas en la materia. Hoy, el avance de las tecnologías de la información y las comunicaciones ha saldado esa discusión. A partir de ello, lo que cobra relevancia no son ya las capacidades técnicas, sino las de gestión de lo que debe ser una política pública, como lo es el manejo de la información de los recursos humanos dedicados a la ciencia en el país. Pero para ello es necesario resolver un tema pendiente que los científicos han dejado plasmado en sus respuestas: el de la falta de una sólida vinculación y coordinación entre las instituciones del Estado.

Conclusiones

Los procesos de evaluación en ciencia y tecnología son una de las principales herramientas para establecer políticas en el sector. La mirada del científico, como evaluador y como evaluado, es fundamental para conocer las verdaderas implicancias que una práctica de evaluación puede tener sobre la investigación. La forma de evaluar es algo que incide de manera directa en la tarea cotidiana del profesional de la ciencia. Respecto de la sensibilidad de este tema, el primer síntoma que observamos en nuestro relevamiento fue el alto nivel de respuestas obtenido.

Al tratar de identificar algunos ejes en torno de los cuales gira la mayoría de los planteos de estos investigadores, que sinteticen las causas que generan tensión, encontramos que hay dos conceptos sobre los que se podrían sustentar gran parte de estas opiniones: 1) todo aquello que es necesario hacer para fortalecer la transparencia; y 2) todo aquello que logre una mayor apertura institucional, evitando así la fuerte sensación de endogamia que perciben los científicos. Desde una mirada global, la reingeniería en los procesos de gestión interna que ha realizado el CONICET, principalmente entre 2003 y 2008, ha sido muy importante. La sistematización de los procesos de evaluación era algo sustancial y se logró con éxito esa primera etapa de la mejora en la gestión. Pero un eficiente proceso de registro de información para la evaluación no necesariamente significa transparencia en la evaluación propiamente dicha. Esto último surge claramente en las expresiones de los encuestados.

La tensión central en este contexto es la dificultad que encuentran los investigadores para poder planificar sus propias carreras y las de sus recursos humanos en formación. No se observan cuestionamientos a la utilización del sistema de pares como mecanismo de validación de la actividad del investigador, lo que se interpreta es que se está frente a un sistema agobiado que, en ocasiones, es permeable a los intereses de grupos no representativos. Los científicos interpretan que la institución concibe la transparencia a partir de otros parámetros. Los argumentos que están en la cima de estas manifestaciones son todos aquellos que se refieren a los criterios de evaluación: respecto de su definición, de su publicación y de su aplicación. De ahí hacia abajo la opacidad es percibida, por ejemplo, desde la forma en que se convoca a los evaluadores hasta la definición del grupo de posibles convocados. Reducidos conjuntos de convocantes y de convocados, más allá de la amplitud definida en la letra de la normativa.

Otro elemento que también pone en tensión la transparencia es la elevada percepción de la comunidad sobre un posible uso indebido de la información a la que se accede al evaluar. La sola idea que esto pueda ocurrir obliga a implementar medidas que disipen dudas. A todo ello se suman los sesgos que interpretan que existen por la falta de criterios claros. Por ejemplo, sobre cómo evaluar una replicación o si debe ser mejor valorada una temática de investigación tradicional por sobre una innovadora, entre otros.

También en el uso de los indicadores bibliométricos no llegan a existir definiciones suficientemente precisas para quienes respondieron. El caso más evidente es el del uso del “factor de impacto” de las revistas y de los datos en general del Journal Citation Reports (JCR). Es amplio al abanico de opiniones sobre estas métricas y sobre su nivel de incidencia, pero es llamativa la absoluta ausencia de toda mención de estos índices en las definiciones del sistema de evaluación del CONICET. Ninguna publicación oficial sobre el proceso parece hacer referencia a ellos. Los detallados manuales de carga del sistema de gestión no especifican cómo es su registro. No se observa a simple vista un criterio formal, por área o por disciplina, que establezca cómo deben ser considerados en la evaluación. Sin embargo, se los utiliza y tienen un peso importante en el proceso. La pregunta es quién determina formalmente su utilización y el peso que van a tener en cada caso. Este tipo de situaciones se contrastan fuertemente con algunos consensos establecidos para las buenas prácticas en la materia. Por ejemplo, cuando el Manifiesto de Leiden (2015) recomienda, en su quinto apartado, que los investigadores afectados por estas mediciones deben conocer y poder verificar cómo han sido consideradas sus contribuciones. Esto además de la citada Ley Nacional de Ciencia, Tecnología e Innovación, que establece la obligación de informar a los evaluados de los criterios que se les aplican.

Finalmente, desde el uso de los CV como una herramienta complementaria para la evaluación, la transparencia también podría ser fortalecida a la vista de los usuarios. Si el científico pudiera contar con un sistema unificado para la carga de su currículum, que luego sea utilizado por todas las instituciones del país sin pedir la misma información en otros formatos, el beneficio más importante que obtendría es el de un mejor aprovechamiento de su recurso más escaso: el tiempo. Pero las señales que reciben no logran aún cristalizarse en ese sentido.

El otro eje que destacamos como central en las expresiones de los encuestados es el que plantea la perspectiva de una institución cerrada en sí misma: existe una clara percepción de endogamia. Nuevamente, comenzando desde los procesos de convocatoria de los evaluadores, se interpreta que el banco real de los pares se integra por círculos de allegados. La expresión “amiguismo” está muy presente en las manifestaciones de los científicos; es necesario erradicar esa idea. La falta de apertura también es percibida en el bajo nivel de convocatoria de evaluadores externos. Tres cuartas partes de los investigadores consultados sostienen que es necesario que participen pares de otros países en no menos de un 30%. Un indicador que también sustenta la necesidad de una mayor apertura en este sentido es el que mide los perfiles de colaboración en las publicaciones científicas (Albornoz et al., 2017). En el ámbito de universidades como la Universidad Nacional de La Plata (UNLP), la Universidad de Buenos Aires (UBA) y la Universidad Nacional de Córdoba (UNC), donde es muy fuerte la presencia de investigadores del CONICET, las tasas de co-publicaciones con autores extranjeros está en cifras que superan el 40 y hasta el 45% de los papers de esas casas de estudio. Si la producción del conocimiento muestra una tendencia hacia una mayor ampliación de las redes de colaboración internacional, la evaluación de este tipo de investigaciones no puede entonces estar ceñida a un reducido entorno institucional. Por todo ello, el tema de falta de apertura fue permeando las respuestas abiertas en la encuesta, destacando particularmente la falta de puentes que logren una articulación con el medio productivo y el sector privado. En términos generales, se trata de una perspectiva que interpela a la gestión por la falta de iniciativas de vinculación que sean sostenidas en el tiempo.

A partir de las respuestas obtenidas y de las entrevistas en profundidad realizadas a miembros de la comunidad, surgieron otros dos temas que no se pueden soslayar en el debate de los aspectos analizados. Se trata, por un lado, de las especificidades del desarrollo científico y de las publicaciones que tienen las disciplinas de las ciencias sociales y las humanidades en comparación con el resto de las áreas. Por otro, el de una tradición cultural fuertemente arraigada en la comunidad científica sobre la forma de evaluar y de llevar adelante las actividades de investigación.

El panorama que se esboza de los resultados del relevamiento es complejo, pero las críticas en su mayoría parten de la base del reconocimiento del prestigio de la institución. Como herramienta central para la implementación de políticas para el sector, los procesos de evaluación deben ser definidos y conducidos de manera centralizada por el órgano principal del gobierno del organismo: su directorio. Pero cuando se reclama transparencia y apertura, lo que se pide son reglas claras y participación en las definiciones. El accionar de la CIECEHCS ha sido un buen ejemplo de pluralidad en dicho sentido. Si este modelo interinstitucional fuera replicado en comisiones por gran área de conocimiento de una forma verdaderamente activa, se produciría una importante oxigenación para todo el sistema. Órganos asesores de este tipo, democráticos, vinculantes, abiertos, permanentes, que sean capaces de monitorear los cambios de cada área, de recibir los planteos de sus integrantes, de velar por una equilibrada conformación de los cuerpos de evaluadores, de definir criterios, actualizarlos, publicarlos, de controlar su aplicación y de garantizar estabilidad en las reglas, atemperarían gran parte de los cuestionamientos. Lo que busca el científico es previsibilidad, no estar sometido a cambios abruptos. Por ello, más que la búsqueda de un adiestramiento en el uso de aplicaciones informáticas, la red institucional de formación debería hoy volcarse a la capacitación de los ingresantes a la CIC sobre los sistemas de evaluación de la ciencia y sobre la importancia de participar en ellos. Así se logrará una mayor apertura, claridad y participación.

Luego, hacia afuera de la institución, se debe buscar una vinculación efectiva con otros sectores que hoy tienen una participación incipiente en el ámbito científico. Además, es necesario generar fuertes y estables lazos de cooperación con el resto de las estructuras del sistema. El desarrollo de aplicaciones para el registro de información es un elemento necesario para la gestión interna, pero no debe ser el medio de articulación institucional, ni deben estar allí concentrados los esfuerzos de la gestión. El CONICET debe ser en el país la nave insignia que transfiera a los organismos del sector el know how sobre las mejores prácticas y para la definición de los más adecuados criterios de evaluación en ciencia y tecnología.

En síntesis, es necesario planificar a mediano y largo plazo. No caer en las recurrentes reformas estructurales que, entre definiciones, aprobaciones e implementaciones, paralizan todo el escenario manteniendo el statu quo bajo la apariencia de un cambio. La falta de prioridades estratégicas se evidencia en las idénticas asignaciones presupuestarias para todas las áreas del conocimiento. Es necesario plantear objetivos claros, alineando los recursos y los estímulos para que el investigador sienta la contención necesaria que le permita afrontar los cambios que exigen los tiempos actuales. Por último, la cultura de nuestra comunidad científica es y será siempre un factor gravitante en todo este escenario, pero no debe ser la excusa para la inacción. No es el cambio cultural lo que se debe planificar; serán la modificación de todos los aspectos previos y el empuje de las nuevas generaciones de investigadores los que transformarán la cultura científica nacional.

1. La literatura gris o no convencional, semi-publicada, invisible, menor o informal, es cualquier ipo de documento que no se difunde por los canales ordinarios de publicación comercial o académica.

2. Los resultados completos de las cuatro dimensiones relevadas en la encuesta se pueden consultar en: http://www.centroredes.org.ar/index.php/encuesta-evaluacion/.

3. Más información disponible en: http://www.conicet.gov.ar/acerca-de-conicet-en-cifras/.